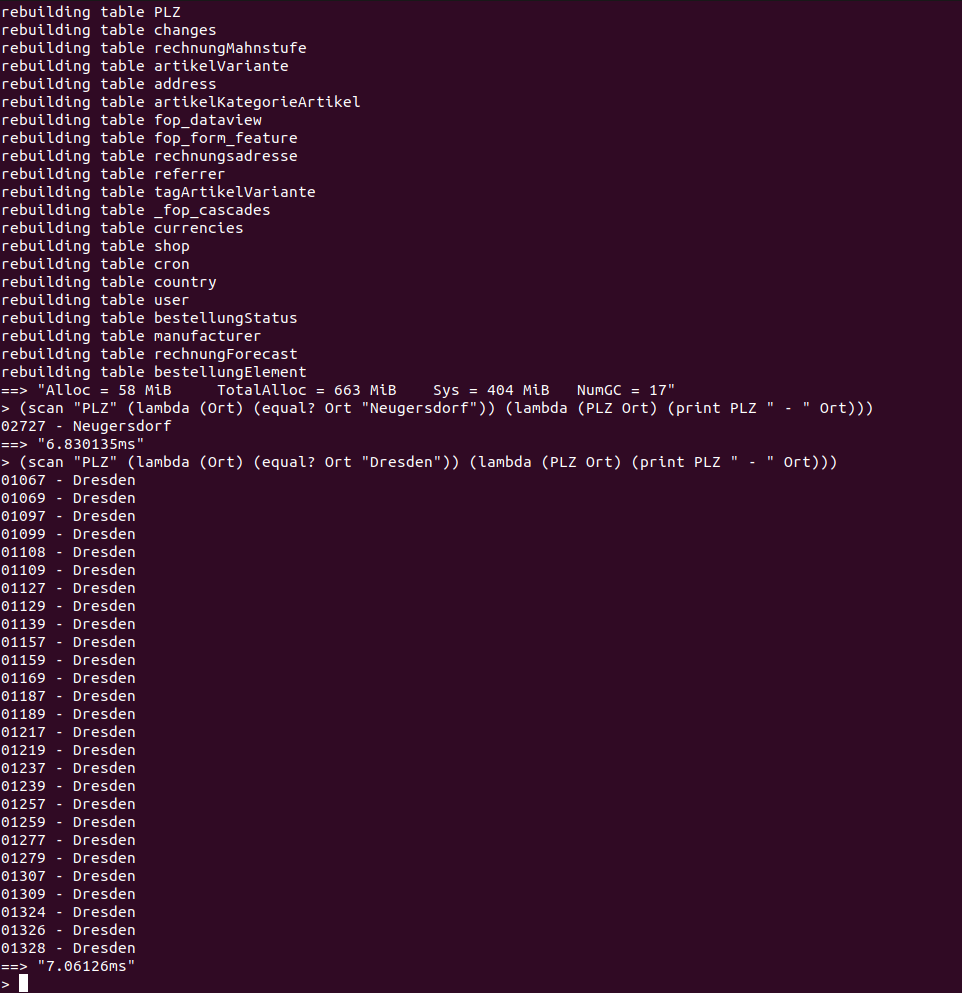

ich stelle heute mal ein etwas ungewöhnliches Projekt vor: eine In-Memory-Datenbank (oder erst mal: Storage Engine) mit String- und Integer-Kompression, die später mal ein vollwertiger Nachbau eienr nicht näher benannten In-Memory-Datenbank eines ERP-Herstellers werden soll.

Kurz zum Abriss: Die DB ist besonders gut für analytische Queries geeignet, da man in einer spaltenbasierten Datenbank viel schneller so etwas wie Summen zusammenrechnen kann.

Dazu blogge ich auch auf launix.de. Der erste Blogbeitrag ist hier zu bestaunen:

https://launix.de/launix/on-designing-a ... in-golang/

https://launix.de/launix/how-to-balance ... workflows/