Linkdump

- xq

- Establishment

- Beiträge: 1590

- Registriert: 07.10.2012, 14:56

- Alter Benutzername: MasterQ32

- Echter Name: Felix Queißner

- Wohnort: Stuttgart & Region

- Kontaktdaten:

Re: Linkdump

UDP-NAT-Punching ohne vorherige Kenntnis des anderen Peers, es reicht, dass eine Seite die IP kennt

https://github.com/samyk/pwnat

https://github.com/samyk/pwnat

War mal MasterQ32, findet den Namen aber mittlerweile ziemlich albern…

Programmiert viel in Zig

Zig und nervt Leute damit.

und nervt Leute damit.

Programmiert viel in

Re: Linkdump

Cool. Zwar schon etwas älter, aber immer noch interessant/relevant.

Das mit den doppelten NATs war mir neu, aber zum Rest: Skype macht das so... O_O

Das mit den doppelten NATs war mir neu, aber zum Rest: Skype macht das so... O_O

Re: Linkdump

Ok, letztendlich bedeutet das aber doch, dass Portfreigabe mehr oder weniger endgültig ausgehebelt ist, oder? Sprich, jetzt hat der kleine Entwickler den Mehraufwand, weil er jetzt solche komplizierteren Techniken implementieren muss, während die ganzen großen Entwickler das einfach nebenher mit machen, oder?

Ist das denn ansonsten eine echte Sicherheitsbedrohung die man raus-patchen wird oder zumindest sollte, oder bleibt das jetzt einfach für immer so?

Ist das denn ansonsten eine echte Sicherheitsbedrohung die man raus-patchen wird oder zumindest sollte, oder bleibt das jetzt einfach für immer so?

Lieber dumm fragen, als dumm bleiben!

https://jonathank.de/games/

https://jonathank.de/games/

- Schrompf

- Moderator

- Beiträge: 5194

- Registriert: 25.02.2009, 23:44

- Benutzertext: Lernt nur selten dazu

- Echter Name: Thomas

- Wohnort: Dresden

- Kontaktdaten:

Re: Linkdump

Hä? NAT-Punchthrough braucht immer eine Gegenseite, die zum gleichen Zeitpunkt mitarbeitet. Da gibt's keine Anlaufstelle, zu der zu irgendnem Zeitpunkt jemand ein Portforwarding einrichten könnte

Früher mal Dreamworlds. Früher mal Open Asset Import Library. Heutzutage nur noch so rumwursteln.

- Chromanoid

- Moderator

- Beiträge: 4302

- Registriert: 16.10.2002, 19:39

- Echter Name: Christian Kulenkampff

- Wohnort: Lüneburg

Re: Linkdump

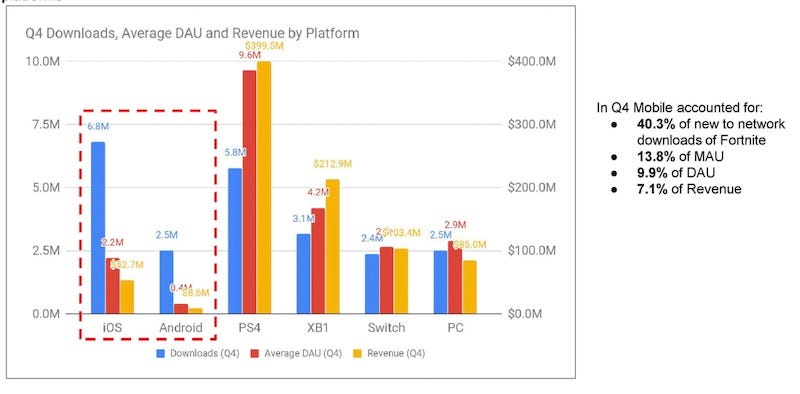

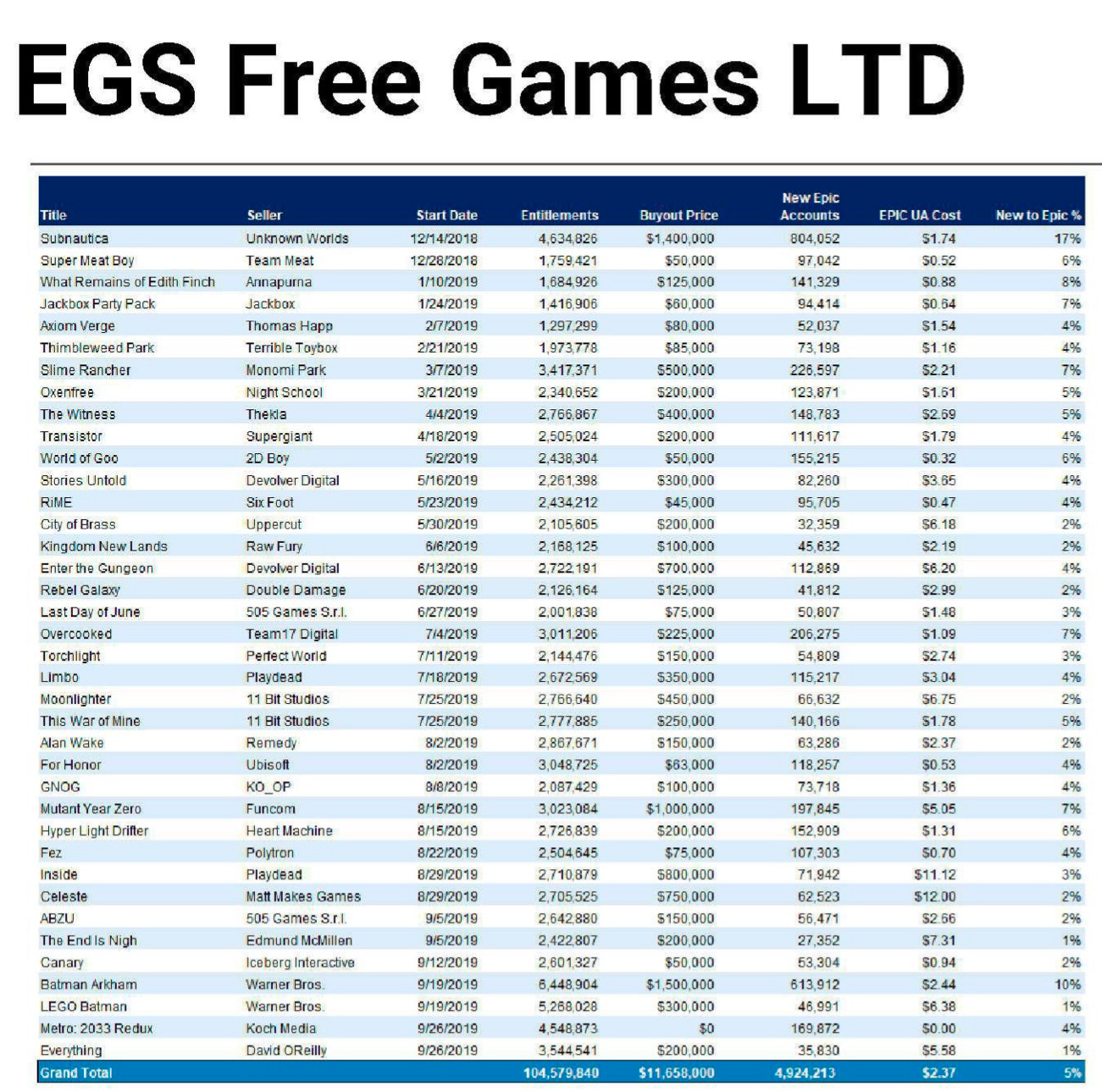

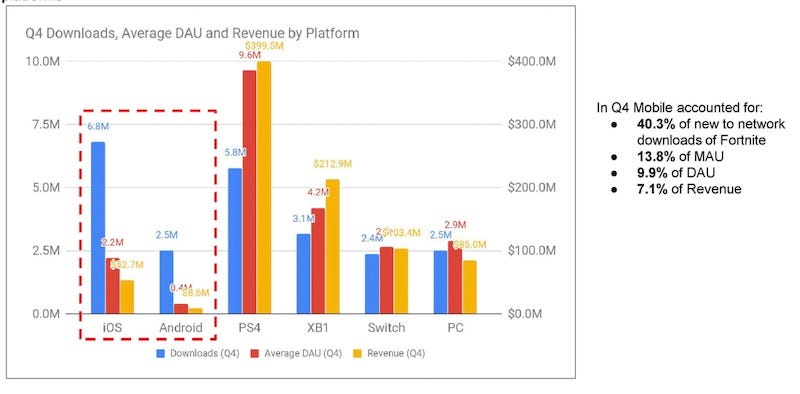

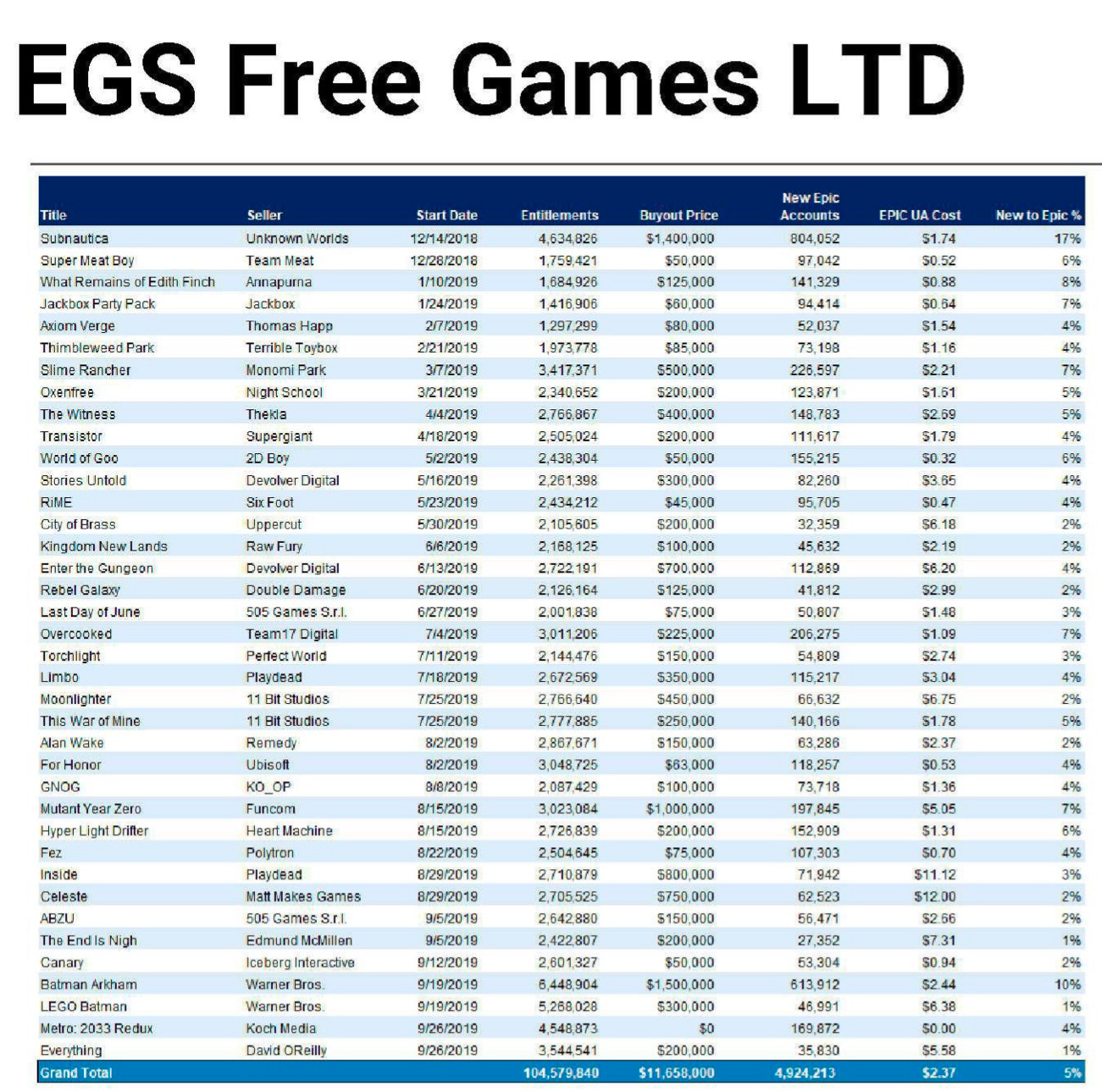

Ziemlich spannende Infos aus dem Epic / Apple Krieg schön zusammengefasst:

https://newsletter.gamediscover.co/p/th ... -takeaways

Fortnite

Free Games

https://newsletter.gamediscover.co/p/th ... -takeaways

Fortnite

Free Games

- Chromanoid

- Moderator

- Beiträge: 4302

- Registriert: 16.10.2002, 19:39

- Echter Name: Christian Kulenkampff

- Wohnort: Lüneburg

Re: Linkdump

https://intel-isl.github.io/PhotorealismEnhancement/ Neuronales Verbessern von Renderings. Ich bin gespannt, was da noch draus wird. Das kommt mir sehr erfolgsversprechend vor - gerade für niedrige LOD-Stufen verbessern (Gras und so).

- Krishty

- Establishment

- Beiträge: 8357

- Registriert: 26.02.2009, 11:18

- Benutzertext: state is the enemy

- Kontaktdaten:

Re: Linkdump

> Video über die fortgeschrittenste Rendering-Technik bisher

> 720p mit 20fps

Das ist hoffentlich bloß Zufall.

> 720p mit 20fps

Das ist hoffentlich bloß Zufall.

- Chromanoid

- Moderator

- Beiträge: 4302

- Registriert: 16.10.2002, 19:39

- Echter Name: Christian Kulenkampff

- Wohnort: Lüneburg

Re: Linkdump

Ja das fand ich auch ziemlich schade. Ich kann mir kaum vorstellen, dass das kein Zufall ist...

edit: huch ich hab da die doppelte Verneinung nicht richtig hinbekommen m(.

edit: huch ich hab da die doppelte Verneinung nicht richtig hinbekommen m(.

- Chromanoid

- Moderator

- Beiträge: 4302

- Registriert: 16.10.2002, 19:39

- Echter Name: Christian Kulenkampff

- Wohnort: Lüneburg

Re: Linkdump

Ich glaube, dass da Absicht hinter steckt. Alles andere macht für mich keinen Sinn. Die Präsentation ist ja sonst ziemlich gepolished. Auch das Erklärvideo haben sie in 4k 60p hinbekommen. Warum nicht die bloßen Aufnahmen? Der Präsentator macht jetzt auch nicht den Eindruck, als wenn er vor solchen Tricks zurückschreckt :)... Dauert halt noch ein bisschen bis so Zeug ausgereift ist. Vielleicht sollte man sich das allg. auch mal auch ohne neuronale Netze anschauen. Keine Ahnung, ob das gemacht wird. Ich meine SSAO o.Ä. erreichen ja auch schon nette Effekte. Neuronale Netze sind da sicher spannend, weil sie unspezifischer arbeiten können. Aber wenn man sich anschaut, dass die im vorgestellten Paper nach Content separieren, könnte ich mir gut vorstellen, dass herkömmliche Algorithmen auf der Ebene auch ebenfalls gute und viel gezieltere Ergebnisse liefern können.

Re: Linkdump

Ziemlich beeindruckend. Vor allen Dingen die temporale Konsistenz fand ich schon ziemlich cool.

Allerdings weiß ich nicht, ob ich das als Rendering-Paper beschreiben würde und ob ich es glaubwürdig finde, dass man damit in Zukunft Spiele macht. Das Netzwerk ist halt auf vorhandenen Datensätzen trainiert und funktioniert daher im Wesentlichen für Straßenszenen. Damit ist die Technik fundamental anders, als Dinge wie DLSS, was man ja prinzipiell für jedes Spiel trainieren kann. Für den Datensatz hier wurden aber halt nicht nur zehntausende Bilder aufgenommen, sondern auch per Hand segmentiert (Und zwar von anderen Forschergruppen, für ein einzelnes Paper wäre der Aufwand dafür viel zu hoch). Und vergleichbare Datensätze gibt es nur für ganz wenige und schon gar nicht für jede Art von Spielszene, die man gerade brauche. Und im Gegensatz zu Einschränkungen wie "es läuft mit 2 FPS auf der schnellsten verfügbaren Grafikkarte" (laut Paper), ist das wirklich ein Problem was man nicht so einfach lösen kann.

Spannender wäre da IMO eine Art "Super-High-Detail"-Mode für Spiele zu erzeugen. Dank Techniken wie Photogrametrie und Raytracing kriegt man das ja prinzipiell hin. Auf jeden Fall dürfte es wesentlich weniger Arbeit sein, Objekte einfach einzuscannen, als einen riesigen Datensatz von Bildern zu erzeugen und zu labeln, mit denen man einen solchen Transfer dann KI getrieben machen kann. Und mehr (künstlerische) Kontrolle hat man sowieso. Und dann könnte man halt versuchen ein Netzwerk zu trainieren, dass normale Renderings auf solche Super-HD Renderings transferiert.

Ich will das Paper nicht schlecht reden, das sieht nach guter Arbeit aus und die Ergebnisse sind toll. Aber es macht halt nicht das, was man vielleicht zunächst denkt. Schon gar nicht, wenn es im Kontext von Spieleprogrammierung gezeigt wird und nicht auf einer Computer-Vision Konferenz.

Allerdings weiß ich nicht, ob ich das als Rendering-Paper beschreiben würde und ob ich es glaubwürdig finde, dass man damit in Zukunft Spiele macht. Das Netzwerk ist halt auf vorhandenen Datensätzen trainiert und funktioniert daher im Wesentlichen für Straßenszenen. Damit ist die Technik fundamental anders, als Dinge wie DLSS, was man ja prinzipiell für jedes Spiel trainieren kann. Für den Datensatz hier wurden aber halt nicht nur zehntausende Bilder aufgenommen, sondern auch per Hand segmentiert (Und zwar von anderen Forschergruppen, für ein einzelnes Paper wäre der Aufwand dafür viel zu hoch). Und vergleichbare Datensätze gibt es nur für ganz wenige und schon gar nicht für jede Art von Spielszene, die man gerade brauche. Und im Gegensatz zu Einschränkungen wie "es läuft mit 2 FPS auf der schnellsten verfügbaren Grafikkarte" (laut Paper), ist das wirklich ein Problem was man nicht so einfach lösen kann.

Spannender wäre da IMO eine Art "Super-High-Detail"-Mode für Spiele zu erzeugen. Dank Techniken wie Photogrametrie und Raytracing kriegt man das ja prinzipiell hin. Auf jeden Fall dürfte es wesentlich weniger Arbeit sein, Objekte einfach einzuscannen, als einen riesigen Datensatz von Bildern zu erzeugen und zu labeln, mit denen man einen solchen Transfer dann KI getrieben machen kann. Und mehr (künstlerische) Kontrolle hat man sowieso. Und dann könnte man halt versuchen ein Netzwerk zu trainieren, dass normale Renderings auf solche Super-HD Renderings transferiert.

Ich will das Paper nicht schlecht reden, das sieht nach guter Arbeit aus und die Ergebnisse sind toll. Aber es macht halt nicht das, was man vielleicht zunächst denkt. Schon gar nicht, wenn es im Kontext von Spieleprogrammierung gezeigt wird und nicht auf einer Computer-Vision Konferenz.

Lieber dumm fragen, als dumm bleiben!

https://jonathank.de/games/

https://jonathank.de/games/

- Chromanoid

- Moderator

- Beiträge: 4302

- Registriert: 16.10.2002, 19:39

- Echter Name: Christian Kulenkampff

- Wohnort: Lüneburg

Re: Linkdump

Ich bin ja immer am rätseln, ob diese Art von neuronalen Netzen im Grunde eine "hübsche Sackgasse" sind. Ich finde es vor allem schade, dass immer so riesige Datasets genutzt werden. Ich frage mich, ob das wirklich sein muss, gerade wenn man 3D-Daten zusätzlich als Eingabe nutzen kann. Ich glaube KNN sind sehr geeignet dazu für das menschliche Auge hinreichende Näherungen hinzupatschen, die dann eben nicht so viel Rechenkapazität benötigen wie traditionelle Algorithmen (mal ein Beispiel, was ich meine: http://www.theorangeduck.com/media/uplo ... f/nnao.pdf).

Re: Linkdump

Ich glaube, dass man diese riesigen Datenmengen prinzipbedingt immer brauchen wird. Du willst ja bei solchen Ansätzen anhand von Beispielen lernen, wie die Realität funktioniert und die Realität ist nunmal sehr kompliziert, also brauchst du extrem viele Beispiele, um das irgendwie abzudecken. Das scheint mir erstmal unumgänglich. Ein paar Dinge die man aber machen kann:

- besser augmentieren (Beispiel für Fotos): Standardmäßig wird das ja eigentlich immer gemacht und gerade für photorealistische Szenen ist das glaube ich schwer. Man kann sehr gut Kameraparameter (Belichtung, Kontrast, Ausschnitt usw.) gut anpassen, aber die Szenen selber eher nicht.

- Unsupervised Learning (Beispiele). Ich bin mir der genauen Fachbegriffe gerade unsicher, aber die Idee ist, dass z.b. Netzwerke selber Korrespondenzen zwischen Bildern lernen. Man gibt dem Netzwerk zwar einen riesigen Berg Fotos, aber die müssen vorher nicht von einem Menschen manuell segmentiert / annotiert werden. D.h. man kann alles, was man z.B. auf Flickr oder so findet direkt benutzen. Typische Egoshooterszenen in Alien Raumschiffen wirst du damit aber auch nicht gelernt bekommen.

- Man kann synthetische Daten benutzen. Das ist total super bei allem was man berechnen kann. Für Super Sampling oder Ambient Occlusion kann man mit ziemlich wenig Aufwand (Änderung der Algorithmen) ziemlich leicht beliebig viele Daten erzeugen und damit sein Netzwerk trainieren. D.h. man braucht genau so viele Daten wie für andere Aufgaben, aber kann halt sehr einfach an diese Daten rankommen. Was ich oben meinte (von Super-HD Mode lernen) geht in die selbe Richtung, nur das man sich eben Mühe gibt, mehr Daten zu erzeugen, dafür dann aber auch mehr Aufgaben lösen kann.

Interessant fand ich ein Kommentar der Entwickler aus dem Black-Mesa Mod für Half-Life. Die Erdlevels in hoher Qualität nachzubauen war halbwegs einfach, die meisten alten Objekte sahen zwar schlecht aus, aber man wusste halt, dass sie ein Stuhl oder eine Tastatur oder sowas sein sollten. Für die Alienwelt Xen galt das nicht, es gab komische Alienstrukturen mit wenig Polygonen und wenig Pixeln und die Entwickler mussten lange überlegen, wie sowas denn jetzt in echt aussehen soll. Prinzipiell ist das also genau das selbe Problem (zu wenig Daten) und es scheint mir ein recht fundamentales zu sein.

Was ich momentan glaube ich mit am spannensten finde ist die Frage, inwieweit man allgemeine Approximationen für Funktionen lernen kann. Soweit ich weiß, muss ja z.B. DLSS für jedes Spiel einzeln trainiert werden, ich schlimmsten Falle sogar für jedes einzelne Level, da nur bei recht ähnlichen Eingabebildern die Qualität maximal wird. Aber wenn man jetzt z.B. den gesamten globalen Lichttransport approximieren könnte (was ja z.B. ein guter Künstler auch tut wenn er ein Bild malt), dann könnte man schon richtig viel Rechenzeit sparen. Und das wäre ja vielleicht auch gerade so ein Effekt, wo unser Auge selbst nicht so genau weiß, was richtig ist und sich von ähnlichen, aber plausiblen Bildern vielleicht ganz gut täuschen lassen könnte.

- besser augmentieren (Beispiel für Fotos): Standardmäßig wird das ja eigentlich immer gemacht und gerade für photorealistische Szenen ist das glaube ich schwer. Man kann sehr gut Kameraparameter (Belichtung, Kontrast, Ausschnitt usw.) gut anpassen, aber die Szenen selber eher nicht.

- Unsupervised Learning (Beispiele). Ich bin mir der genauen Fachbegriffe gerade unsicher, aber die Idee ist, dass z.b. Netzwerke selber Korrespondenzen zwischen Bildern lernen. Man gibt dem Netzwerk zwar einen riesigen Berg Fotos, aber die müssen vorher nicht von einem Menschen manuell segmentiert / annotiert werden. D.h. man kann alles, was man z.B. auf Flickr oder so findet direkt benutzen. Typische Egoshooterszenen in Alien Raumschiffen wirst du damit aber auch nicht gelernt bekommen.

- Man kann synthetische Daten benutzen. Das ist total super bei allem was man berechnen kann. Für Super Sampling oder Ambient Occlusion kann man mit ziemlich wenig Aufwand (Änderung der Algorithmen) ziemlich leicht beliebig viele Daten erzeugen und damit sein Netzwerk trainieren. D.h. man braucht genau so viele Daten wie für andere Aufgaben, aber kann halt sehr einfach an diese Daten rankommen. Was ich oben meinte (von Super-HD Mode lernen) geht in die selbe Richtung, nur das man sich eben Mühe gibt, mehr Daten zu erzeugen, dafür dann aber auch mehr Aufgaben lösen kann.

Interessant fand ich ein Kommentar der Entwickler aus dem Black-Mesa Mod für Half-Life. Die Erdlevels in hoher Qualität nachzubauen war halbwegs einfach, die meisten alten Objekte sahen zwar schlecht aus, aber man wusste halt, dass sie ein Stuhl oder eine Tastatur oder sowas sein sollten. Für die Alienwelt Xen galt das nicht, es gab komische Alienstrukturen mit wenig Polygonen und wenig Pixeln und die Entwickler mussten lange überlegen, wie sowas denn jetzt in echt aussehen soll. Prinzipiell ist das also genau das selbe Problem (zu wenig Daten) und es scheint mir ein recht fundamentales zu sein.

Was ich momentan glaube ich mit am spannensten finde ist die Frage, inwieweit man allgemeine Approximationen für Funktionen lernen kann. Soweit ich weiß, muss ja z.B. DLSS für jedes Spiel einzeln trainiert werden, ich schlimmsten Falle sogar für jedes einzelne Level, da nur bei recht ähnlichen Eingabebildern die Qualität maximal wird. Aber wenn man jetzt z.B. den gesamten globalen Lichttransport approximieren könnte (was ja z.B. ein guter Künstler auch tut wenn er ein Bild malt), dann könnte man schon richtig viel Rechenzeit sparen. Und das wäre ja vielleicht auch gerade so ein Effekt, wo unser Auge selbst nicht so genau weiß, was richtig ist und sich von ähnlichen, aber plausiblen Bildern vielleicht ganz gut täuschen lassen könnte.

Lieber dumm fragen, als dumm bleiben!

https://jonathank.de/games/

https://jonathank.de/games/

- Krishty

- Establishment

- Beiträge: 8357

- Registriert: 26.02.2009, 11:18

- Benutzertext: state is the enemy

- Kontaktdaten:

Re: Linkdump

Jemand hat sich Nanite (das mit den Milliarden Dreiecken) in RenderDoc angeschaut: http://www.elopezr.com/a-macro-view-of-nanite/

Enthält lustige Tricks, wie dass der Compute Shader Quads erzeugt, die dann wiederum auf den Viewport gerendert werden.

Enthält lustige Tricks, wie dass der Compute Shader Quads erzeugt, die dann wiederum auf den Viewport gerendert werden.

- xq

- Establishment

- Beiträge: 1590

- Registriert: 07.10.2012, 14:56

- Alter Benutzername: MasterQ32

- Echter Name: Felix Queißner

- Wohnort: Stuttgart & Region

- Kontaktdaten:

Re: Linkdump

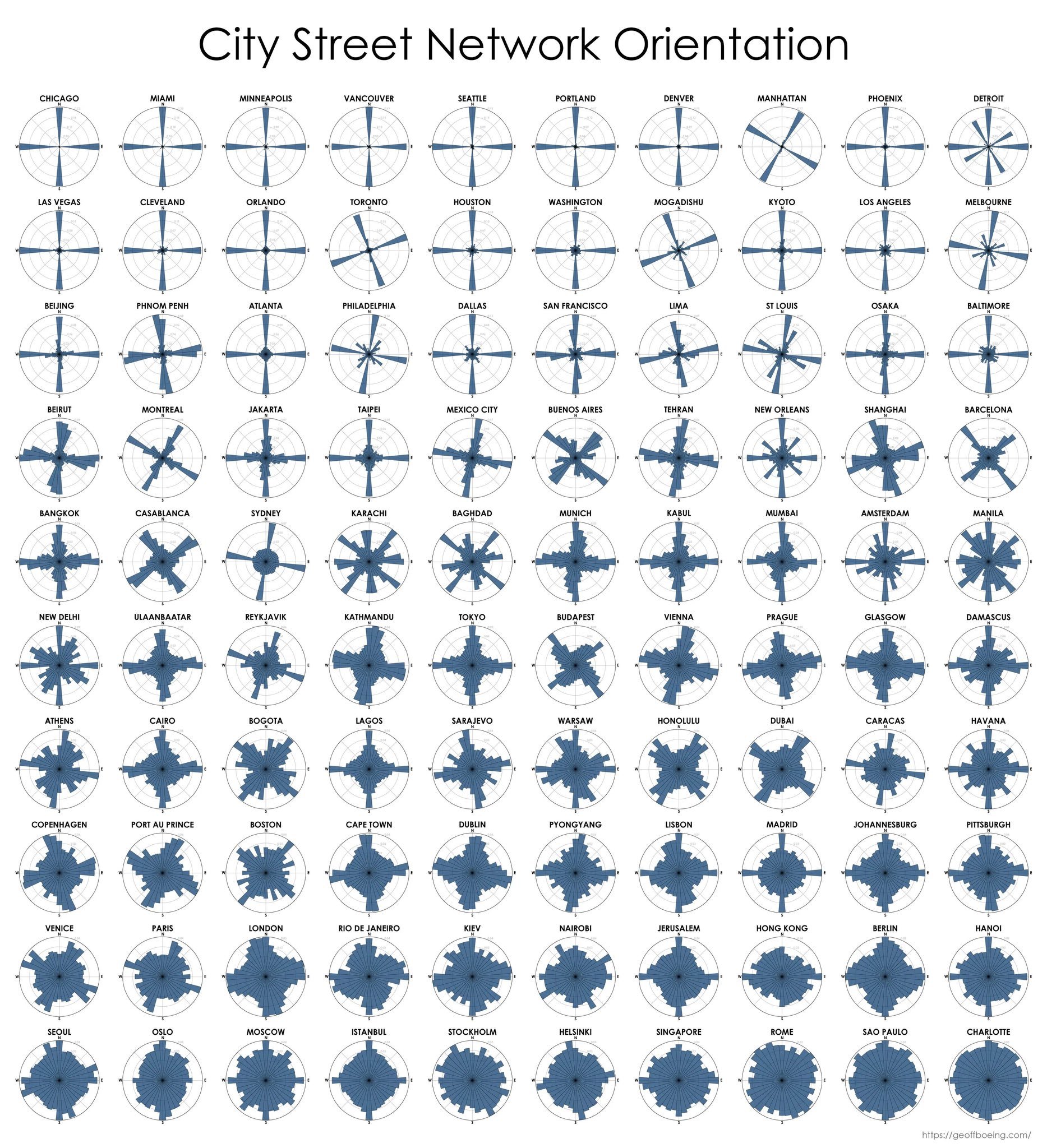

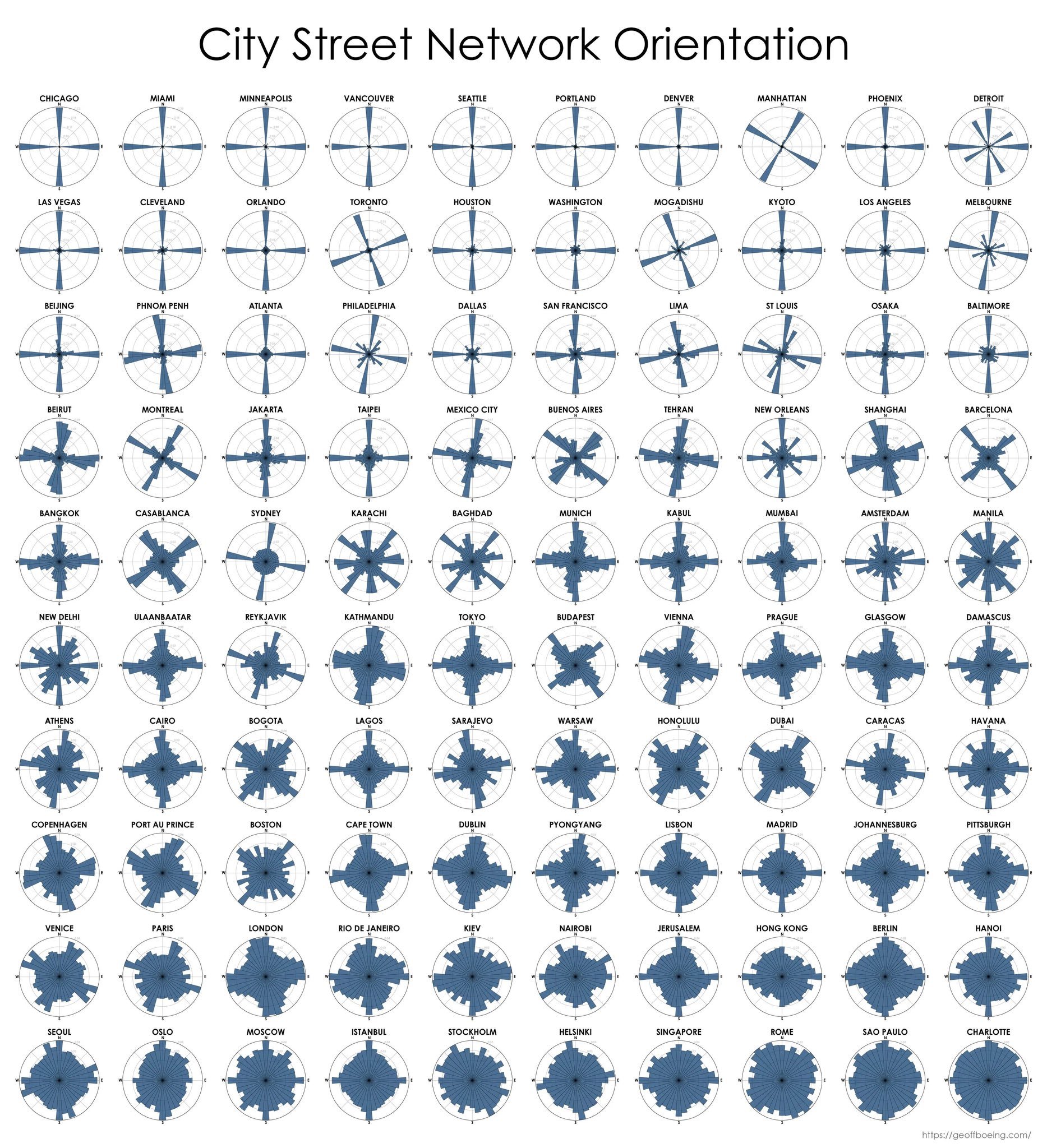

https://twitter.com/emollick/status/140 ... 20/photo/1

Visualisierung der Straßenrichtung diverser Städte

Visualisierung der Straßenrichtung diverser Städte

War mal MasterQ32, findet den Namen aber mittlerweile ziemlich albern…

Programmiert viel in Zig

Zig und nervt Leute damit.

und nervt Leute damit.

Programmiert viel in

- Krishty

- Establishment

- Beiträge: 8357

- Registriert: 26.02.2009, 11:18

- Benutzertext: state is the enemy

- Kontaktdaten:

Re: Linkdump

Das BeamNG-Team hat einen Artikel über die Probleme, ihr Deformationsmodell auf Reifen anzuwenden: https://beamng.com/game/news/blog/tire-physics-changes/

Ähnliche Artikel vom iRacing-Team 2010: https://www.iracing.com/the-sticking-po ... ing-tires/ und https://www.iracing.com/physics-modelin ... info-plus/

Reifen sind und bleiben die härteste Nuss in Rennspielen.

Ähnliche Artikel vom iRacing-Team 2010: https://www.iracing.com/the-sticking-po ... ing-tires/ und https://www.iracing.com/physics-modelin ... info-plus/

Reifen sind und bleiben die härteste Nuss in Rennspielen.

- Chromanoid

- Moderator

- Beiträge: 4302

- Registriert: 16.10.2002, 19:39

- Echter Name: Christian Kulenkampff

- Wohnort: Lüneburg

Re: Linkdump

https://factorio.com/blog/post/fff-366 TDD from the Factorio Team (factorio.com) [via https://news.ycombinator.com/item?id=27549143]

- xq

- Establishment

- Beiträge: 1590

- Registriert: 07.10.2012, 14:56

- Alter Benutzername: MasterQ32

- Echter Name: Felix Queißner

- Wohnort: Stuttgart & Region

- Kontaktdaten:

Re: Linkdump

Der 1$ Stroke Recognizer für Gesten:

http://depts.washington.edu/acelab/proj ... index.html

sowie der 1€-Input-Filter für Maus-/Touch-/Joystick-Input:

https://cristal.univ-lille.fr/~casiez/1euro/

http://depts.washington.edu/acelab/proj ... index.html

sowie der 1€-Input-Filter für Maus-/Touch-/Joystick-Input:

https://cristal.univ-lille.fr/~casiez/1euro/

War mal MasterQ32, findet den Namen aber mittlerweile ziemlich albern…

Programmiert viel in Zig

Zig und nervt Leute damit.

und nervt Leute damit.

Programmiert viel in

Re: Linkdump

Haha, der $1-Algo.

Mehr als 1 Dollar ist der anscheinend auch nicht Wert: Ganz offensichtlich ist das das "v" :-)

Mehr als 1 Dollar ist der anscheinend auch nicht Wert: Ganz offensichtlich ist das das "v" :-)

Re: Linkdump

Jaa, das in den Klammern scheint zwar die Wahrscheinlichkeit zu sein, aber es scheint nicht immer möglich zu sein z.B. nur Eingaben über 0.9 zu akzeptieren, weil auch manche recht ordentliche Zeichnungen manchmal nicht diese Qualität erreichen.

Aber insgesamt muss ich sagen, dass wenn ich mich halbwegs anstrenge eine Form nachzumalen, die auch ziemlich gut erkannt werden. Das Problem ist also eher Fehleingaben auszusortieren.

Andererseits finde ich so Gesten aber für fast alle Anwendungsgebiete eh doof. Arx Fatalis hat das ja fürs Zaubern benutzt, aber in einem EgoShooter war das echt fehl am Platz. Mir fällt eigentlich spontan nichts ein, wofür ich sie benutzen wollen würde, was schade ist, weil die Technologie ja eigentlich cool ist.

Aber insgesamt muss ich sagen, dass wenn ich mich halbwegs anstrenge eine Form nachzumalen, die auch ziemlich gut erkannt werden. Das Problem ist also eher Fehleingaben auszusortieren.

Andererseits finde ich so Gesten aber für fast alle Anwendungsgebiete eh doof. Arx Fatalis hat das ja fürs Zaubern benutzt, aber in einem EgoShooter war das echt fehl am Platz. Mir fällt eigentlich spontan nichts ein, wofür ich sie benutzen wollen würde, was schade ist, weil die Technologie ja eigentlich cool ist.

Lieber dumm fragen, als dumm bleiben!

https://jonathank.de/games/

https://jonathank.de/games/

Re: Linkdump

Ahja, man versucht halt das nächst-beste zu treffen.

Wenn man gerade sowas braucht, isses aber schon nicht schlecht.

Aber der 1€ Algo sieht interessant aus, da geht was.

Wenn man gerade sowas braucht, isses aber schon nicht schlecht.

Aber der 1€ Algo sieht interessant aus, da geht was.

- xq

- Establishment

- Beiträge: 1590

- Registriert: 07.10.2012, 14:56

- Alter Benutzername: MasterQ32

- Echter Name: Felix Queißner

- Wohnort: Stuttgart & Region

- Kontaktdaten:

Re: Linkdump

Ja, man muss den 1$ mit wesentlich mehr Input füttern, damit da sinnvoller Kram bei rauskommt. Ist aber ziemlich cool

War mal MasterQ32, findet den Namen aber mittlerweile ziemlich albern…

Programmiert viel in Zig

Zig und nervt Leute damit.

und nervt Leute damit.

Programmiert viel in

- Krishty

- Establishment

- Beiträge: 8357

- Registriert: 26.02.2009, 11:18

- Benutzertext: state is the enemy

- Kontaktdaten:

Re: Linkdump

Volumenlichter deutlich schneller berechnen, indem man ihre Silhouette bestimmt und das Problem auf 2D reduziert: Real-Time Shading with Polyhedral Lights using Silhouette Detection

Sehr beeindruckend nicht nur wenn man bedenkt, dass das ohne Ray Tracing auskommt. Ich überlege, wie man das für Ambient Occlusion oder Global Illumination missbrauchen könnte …

Sehr beeindruckend nicht nur wenn man bedenkt, dass das ohne Ray Tracing auskommt. Ich überlege, wie man das für Ambient Occlusion oder Global Illumination missbrauchen könnte …

-

joggel

Re: Linkdump

Ich habe ja im Zuge meiner Recherche nach CSG-Zeugs ein paar interessante Seiten gefunden.

Am Ende habe ich ja eigentlich nichts selber implementiert *shame on me* :D

Habe mir aber schon alle Information zusammen gesucht die ich dazu bräuchte.... so war zumindest mein Plan.

Ich weiß nicht ob diese Seiten bekannt sind... für mich waren sie neu (wenn auch manche so aussehen als werden sie nicht mehr aktualisiert).

http://www.realtimerendering.com/portal.html

Falls irgendwer irgendwann mal in die Verlegenheit kommt zb ein Dreieck-vs-Dreick-Intersectiontest zu schreiben, oder Sphere-vs-Plane, oder was auch immer:

http://www.realtimerendering.com/intersections.html

Codesammlung bzw Engine für alles was mit Geometrie und Grafik zu tun hat:

https://www.geometrictools.com/index.html

Sah mir auch ganz interessant aus und hab mal ein Lesezeichen gesetzt.

http://erich.realtimerendering.com/

Wie gesagt: ich habe mir diese Seiten einfach mal abgespeichert weil sie ziemlich nützlich aussahen; auch wenn ich in dieser Richtung noch nie, bis kaum, etwas gemacht habe.

Müssen halt die coolen Kids entscheiden ob's was taugt :P

Nachtrag:

Ich würde gerne wissen wo ich die Beschreibung mancher Algorithmen finde, die benutzt werden. Das steht zum Beispiel auf diese Seite:

3DGEA, Section 4.1.1: Billboards

3DGEA, Section 8.2.1: BillboardNode Sample

3DGED2, Section 7.1: Sprites and Billboards

Aber was bedeutet dieses "3DGEA"?

Am Ende habe ich ja eigentlich nichts selber implementiert *shame on me* :D

Habe mir aber schon alle Information zusammen gesucht die ich dazu bräuchte.... so war zumindest mein Plan.

Ich weiß nicht ob diese Seiten bekannt sind... für mich waren sie neu (wenn auch manche so aussehen als werden sie nicht mehr aktualisiert).

http://www.realtimerendering.com/portal.html

Falls irgendwer irgendwann mal in die Verlegenheit kommt zb ein Dreieck-vs-Dreick-Intersectiontest zu schreiben, oder Sphere-vs-Plane, oder was auch immer:

http://www.realtimerendering.com/intersections.html

Codesammlung bzw Engine für alles was mit Geometrie und Grafik zu tun hat:

https://www.geometrictools.com/index.html

Sah mir auch ganz interessant aus und hab mal ein Lesezeichen gesetzt.

http://erich.realtimerendering.com/

Wie gesagt: ich habe mir diese Seiten einfach mal abgespeichert weil sie ziemlich nützlich aussahen; auch wenn ich in dieser Richtung noch nie, bis kaum, etwas gemacht habe.

Müssen halt die coolen Kids entscheiden ob's was taugt :P

Nachtrag:

Ich würde gerne wissen wo ich die Beschreibung mancher Algorithmen finde, die benutzt werden. Das steht zum Beispiel auf diese Seite:

3DGEA, Section 4.1.1: Billboards

3DGEA, Section 8.2.1: BillboardNode Sample

3DGED2, Section 7.1: Sprites and Billboards

Aber was bedeutet dieses "3DGEA"?

- Schrompf

- Moderator

- Beiträge: 5194

- Registriert: 25.02.2009, 23:44

- Benutzertext: Lernt nur selten dazu

- Echter Name: Thomas

- Wohnort: Dresden

- Kontaktdaten:

Re: Linkdump

Das ist ein Buchname, glaube ich. "3D Game Engine Architecture" und "3D Game Engine Design"

Früher mal Dreamworlds. Früher mal Open Asset Import Library. Heutzutage nur noch so rumwursteln.

-

joggel

-

joggel

Re: Linkdump

Falls jemand mal Maps vom Mond braucht:

https://trek.nasa.gov/moon

Falls jemand gerne in die Sterne schaut:

https://stellarium-web.org/

https://trek.nasa.gov/moon

Falls jemand gerne in die Sterne schaut:

https://stellarium-web.org/

-

joggel

Re: Linkdump

Ich finde vieles von diesem Matt Keeter echt interessant!

Verirre mich immer gerne auf seine Seite.

Ich halte auch diese Arbeit für wertvoll:

https://www.mattkeeter.com/research/mpr/

(Sowas wie SDF, nur unterteilt in Tiles (2D) bzw Voxeln (3D) und mittels GPU parallelisiert und so :P )

ALso wenn ich sage "Sowas wie SDF" dann meine ich, dass Geometrie über mathematische Funktionen definiert wird^^

Verirre mich immer gerne auf seine Seite.

Ich halte auch diese Arbeit für wertvoll:

https://www.mattkeeter.com/research/mpr/

(Sowas wie SDF, nur unterteilt in Tiles (2D) bzw Voxeln (3D) und mittels GPU parallelisiert und so :P )

ALso wenn ich sage "Sowas wie SDF" dann meine ich, dass Geometrie über mathematische Funktionen definiert wird^^

Re: Linkdump

Huh, schreibt mal eben in seiner Freizeit ohne Co-Autoren ein Siggraph-Paper. Nicht schlecht, bzw. recht beeindruckend!

Lieber dumm fragen, als dumm bleiben!

https://jonathank.de/games/

https://jonathank.de/games/

-

joggel

Re: Linkdump

Hehe, ja!

Mich beeindruckt der Typ (das Mensch) übelst.

Kann ich nur empfehlen. Sollte man sich merken und aufm Schirm habe, mMn :)

Mich beeindruckt der Typ (das Mensch) übelst.

Kann ich nur empfehlen. Sollte man sich merken und aufm Schirm habe, mMn :)